Perfiles armados: el uso de Facebook por las disidencias de las Farc - Botando Corriente #43

Además: Nuevas reglas de YouTube y Meta para combatir la IA | Cómo la IA puede combatir los discursos de odio en redes sociales

Las reglas del juego🦾

YouTube y Meta anuncian nuevas políticas contra la inteligencia artificial

El auge de los modelos generativos de texto y video han facilitado la propagación de narrativas de desinformación más persuasivas y elaboradas en el ecosistema digital. Ante este escenario, la semana pasada, tanto Youtube como Meta, dieron a conocer nuevas políticas para afrontar estos desafíos.

En el caso de YouTube, la plataforma permitirá que aquellas personas cuya voz o imagen sea imitada de manera artificial puedan pedir la eliminación de un video. De acuerdo con la compañía, esta opción estará disponible incluso para empresas discográficas cuando se simule el canto de un artista. Según un comunicado, antes de remover un contenido se tendrán en cuenta varios factores, incluyendo si se trata de una sátira o una parodia, contenidos protegidos por sus políticas de contenido.

Además, la plataforma exigirá que los usuarios indiquen si su contenido fue generado o modificado mediante IA generativa, en cuyo caso se aplicará una etiqueta en el panel de descripción o sobre la barra de reproducción del video. Si se oculta esta información, las publicaciones podrán ser eliminadas y los creadores de contenido suspendidos del programa de socios de YouTube.

La compañía advierte que en otros casos la etiqueta no será suficiente para mitigar riesgos, especialmente en temas delicados como elecciones o conflictos en curso, por lo cual los contenidos serán eliminados cuando incumplan sus políticas de contenido.

Meta, por su parte, indicó que actualizará su política de publicidad para que los anunciantes revelen si un anuncio relacionado con temas políticos o sociales ha sido generado o modificado artificialmente. La medida busca enfrentar situaciones en las que, por ejemplo, se utilice la imagen de una persona real para decir algo que nunca dijo, como ocurrió en el caso reciente de los ‘deepfakes’ de Javier Milei durante la campaña presidencial en Argentina.

Perfiles armados: el uso de Facebook por las disidencias de las Farc

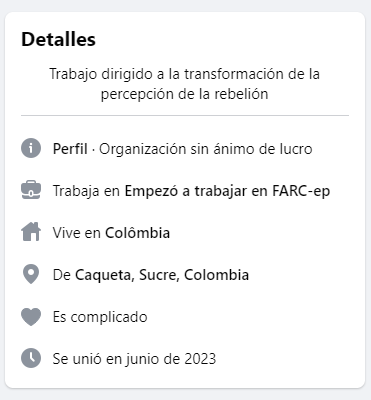

“Estado: Soltero. Vive en: Arauca. Trabaja en: Columna móvil Titiro Martínez Farc-EP”, se lee en la descripción de un usuario en Facebook. El perfil hace parte de un grupo de 50 cuentas de miembros de las disidencias de las Farc en esta red social detectadas por La Silla Vacía. En alianza con este medio, analizamos la presencia de los miembros de este grupo armado en la plataforma.

Los usuarios registrados pertenecen al Estado Mayor Central (EMC) de las Farc-EP, una disidencia de la guerrilla desmovilizada tras los acuerdos de paz en Colombia en 2016, y ahora incluida en la ‘Paz Total’, la política del gobierno de Gustavo Petro para un nuevo proceso de negociación con grupos armados y bandas criminales en el país.

En los perfiles de los integrantes del EMC abundan imágenes en los que portan armas, visten los uniformes camuflados de la guerrilla y muestran imágenes de plantaciones de coca. “Es como si fuera un grupo de teatro, que publica en redes sociales como si nada” le dijo a La Silla Vacía Pastor Alape, exmiembro de las antiguas Farc.

No es la primera vez que los conflictos y los grupos armados o de crimen organizado de América Latina saltan a la esfera digital. En 2020, el New York Times informó sobre una tendencia en TikTok en los que contenidos que enaltecían la cultura del narcotráfico –con corridos mexicanos de fondo– se volvían virales en esa plataforma. A su vez, un reporte de la Oficina de las Naciones Unidas contra la Droga y Delito registró el año pasado que grupos de narcotráfico estaban ejerciendo sus actividades a través de redes sociales en la región.

Las tensiones con la moderación de contenidos

La presencia de miembros de esta organización en la plataforma, así como buena parte del contenido que difunden, infringe las normas de Facebook. Para evitar convertirse en centros de promoción del terrorismo o en un medio de reclutamiento, la plataforma contempla algunas prohibiciones para tratar este tipo de contenido.

La política de personas y organizaciones peligrosas de la compañía clasifica a estos sujetos en tres niveles, teniendo en cuenta su comportamiento en línea y fuera de la web. El primer nivel abarca organizaciones terroristas, entidades de odio y grupos de crimen organizado a gran escala. Como ejemplo, en esta categoría se incluyen las entidades designadas como Organizaciones Terroristas Extranjeras por el gobierno de Estados Unidos.

Como resultado de las negociaciones de paz, en 2021 la Secretaría de Estado de Estados Unidos revocó la calificación de grupo terrorista extranjero a las Farc, pero la mantuvo para las facciones que no se acogieron al proceso.

De cualquier forma, las disidencias que están utilizando Facebook cumplen además con otros criterios de la compañía para considerar a una organización como terrorista: tener objetivos políticos o ideológicos y participar en actos de violencia que afectan a la población civil. Al respecto, las políticas prohíben la presencia de estas entidades en sus plataformas y no permiten contenidos que las exalten, les ofrezcan apoyo sustancial o las representen.

Muchas de las cuentas registradas por La Silla Vacía aprovechan Facebook para compartir información y publicar comunicados oficiales. Además, los usuarios indican en la casilla de información de su perfil que trabajan o ejercen un cargo en las Farc-EP.

Los perfiles publican contenido a favor de la organización, como supuestos actos de reforestación, reels de enfrentamientos con canciones de fondo, e invitaciones a la población a sumarse a su causa. Por ejemplo, el pasado 5 de octubre, la cuenta del ‘Bloque Jorge Suárez Briceño’ publicó un video en el que jóvenes camuflados y armados animan a integrar las filas del grupo. “Únete a nuestra lucha, te esperamos”, dice una mujer en la publicación.

La mayoría de los contenidos que promueven y representan al EMC en Facebook corresponden a cuentas personales cuyo alcance es limitado, pues no cuentan con una cantidad significativa de amigos o seguidores. En parte, la baja visibilidad podría explicar que pasen inadvertidos por los sistemas de detección de la compañía o por otros usuarios que las reporten.

A pesar de difundir contenidos a favor de las disidencias, no parece tratarse de una campaña de coordinación para difundir propaganda de la organización, sino una actividad auténtica. Si bien durante el conflicto armado en Colombia los integrantes de grupos armados procuraban mantenerse en la clandestinidad, este fenómeno de exposición en Facebook puede explicarse en parte porque las bases de la organización están conformadas por una generación que creció con acceso a las redes sociales, como le explicó a La Silla Vacía Kyle Johnson, cofundador de Conflict Responses, una organización que investiga la desinformación alrededor del conflicto armado y la construcción de paz en Colombia.

Lee el artículo de La Silla Vacía en alianza con Circuito.

Polo a tierra🛑

La inteligencia artificial podría combatir el discurso de odio en redes sociales

Una investigación publicada esta semana indica que los modelos generativos de lenguaje podrían ser utilizados para mitigar ataques a grupos vulnerables en redes sociales. Basado en los sistemas de OpenAI, un grupo de académicos de las universidades de Varsovia y Ámsterdam desarrolló un modelo capaz de identificar publicaciones discriminatorias en X –antes Twitter– dirigidas contra refugiados ucranianos en Polonia y generar respuestas que contrarresten dichos ataques.

El experimento consistió en crear una cuenta en la plataforma para que un bot respondiera a las publicaciones de odio en menos de cuatro horas, disminuyendo la posibilidad de que tuvieran mayor alcance. Para garantizar que las respuestas estuvieran fundamentadas y fueran creíbles, el modelo fue entrenado con artículos de medios de comunicación confiables que neutralizan ideas en contra de los refugiados ucranianos.

De acuerdo con la investigación, el experimento redujo la cantidad de likes y de impresiones de los contenidos potencialmente dañinos. A su vez, las respuestas del bot provocaron que otros usuarios se involucraran más en las discusiones, lo que podría sugerir una ruptura en la burbuja de información. Sin embargo, el documento advierte que falta mayor investigación para interpretar este fenómeno.

El trabajo se presenta en un momento en el que la guerra en Medio Oriente ha disparado los indicadores de discursos de odio en X. Según los autores, la base de este trabajo “podría ayudar a desarrollar mejores herramientas y sistemas para construir comunidades en línea más seguras”.